Goforce

Hardcore Gamer

Je l'avais dit : pAMD FSR 2.0 Quality & Performance Review - The DLSS Killer | TechPowerUp

La conclusion est assez enthousiaste! Ca fait plaisir. Faut espérer que beaucoup de jeux suivent rapidement et que ça arrive sur les Xbox Series.

" AMD has achieved the unthinkable—the new FidelityFX Super Resolution FSR 2.0 looks amazing, just as good as DLSS 2.0, actually DLSS 2.3 (in Deathloop). Sometimes even slightly better, sometimes slightly worse, but overall this is a huge win for AMD. "

En sachant que le FSR 2.0 ... est open source.

Si des génies (autre que les dev/ingé d'amd) l'améliorent, c'est tout bénéf pour tout le monde : p (et c'est ce qui est déjà arrivé sur le FSR 1.0)

Le DLSS 2.4+ est "théoriquement" toujours supérieur au FSR 2.0 mais la différence est nettement moins visible ... (le DLSS 2.X nécessite beaucoup plus de temps pour être implémenter)

Il n'y a pas directX sur PS5 et la PS5 n'a pas un "vrai" GPU RDNA2.les ps5 sont aussi base sur une archi amd non?

ca va faire un bon gros coup dans le bide de nvidia tt ca...

Le support du FSR 1.0 n'est que partiel sur PS5 et le FSR 2.0 ne fonctionne pas sur celle-ci. (en tout cas le FSR 2.0 ne peut pas fonctionner nativement sur PS5, après comme la techno est open source, sony peut peut-être l'adapter, notamment sur les jeux sous unreal engine)

FSR 1.0 fonctionne sur DX11, DX12 & Vulkan. https://gpuopen.com/fidelityfx-superresolution/ (et fonctionne sur tous les GPU compatible DX11 minimum)

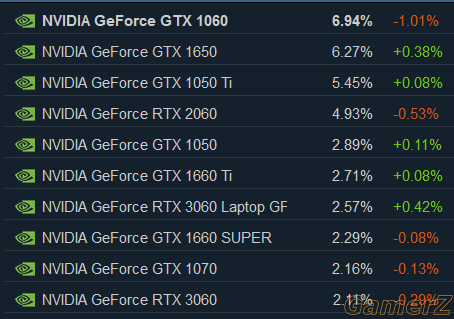

FSR 2.0 fonctionne sur DX12 & Vulkan. https://gpuopen.com/fidelityfx-superresolution-2/ (et fonctionne sur les GPU RX 500, GTX 10XX et plus récent)

Les FSR 1.X et 2.X fonctionneront aussi sur les GPU Arc de intel.

Il y a déjà minimum 2 jeux avec le FSR 1.0 sur xbox series, Chernobylite et lego builders, les autres jeux seront maj cette année

A ma connaissance, il n'y a qu'un seul jeu à utiliser le "FSR 1.0" sur PS5 (via l'unreal engine) : Arcadegeddon (d'autres jeux arrivent)

Mais oui le fait que le FSR 2.0 soit dispo sur les xbox series, steam deck et la totalité des gpu compatible DX12 ultimate (RX 5XX minimum, GTX 10XX minimum, ARC) va faire mal à nvidia puisque les dev vont plutôt se tourner en prio vers le FSR 2.0. (après je penses que pas mal de dev vont choisir de mettre le FSR 2.0 & le DLSS)

Nvidia vient quand même de perdre un argument de poids ... pour ses RTX.

-

Ceux qui ont une RX 6XXX, je vous conseil d'installer les nouveaux drivers preview de mai ...

Le gain en performance est tellement énorme sur la totalité des jeux en DX11, ça touche même certains jeux DX12.

On a rarement vu un driver apporté autant de perf, que ce soit chez AMD ou Nvidia.

C'est simple, les reviews postée sans ce driver sont devenue useless.