Je comprends le scepticisme vis-à-vis de certaines théories, mais les neurosciences ont quand même fourni des modèles quantitatifs (predictive coding, free-energy, etc.) qui expliquent pas mal de données expérimentales.

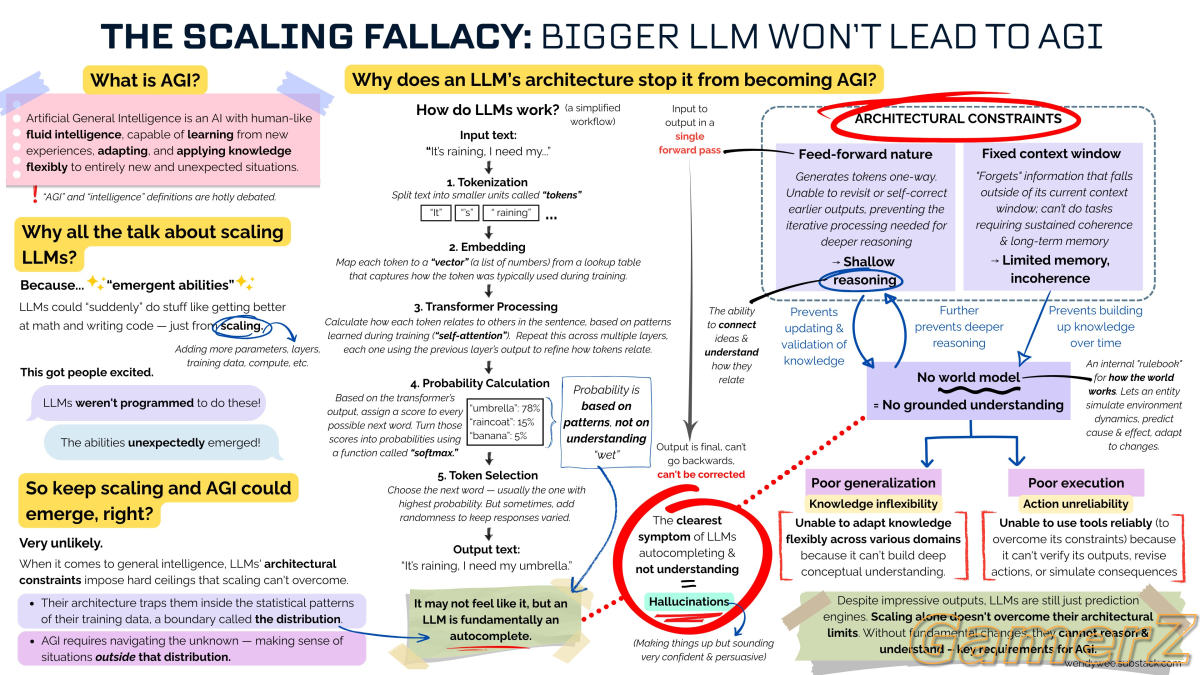

Le lien que tu partages sur la neurosymbolic AI va dans le même sens: c'est justement en hybridant l'approche statistique (très "cerveau-like") avec des contraintes symboliques qu'on espère réduire les hallucinations.

Donc, même si " le cerveau = machine à stats " est un raccourci, les mécanismes de feedback sensorimoteur et de méta-cognition donnent des pistes concrètes pour faire évoluer les LLM au-delà du simple "autocomplete géant". Les neurosciences ne règlent pas tout, mais elles inspirent déjà des solutions techniques.

PS: Je réagissais au fait qu'effectivement, grossir les LLM n'est pas la solution. Je suis également convaincu que la neuroscience nous aidera pour faire de meilleur modèle comme l'IA nous aidera à mieux comprendre ce qu'on a dans le crâne. Après je ne connais pas tout non plus.