Sauf que si tes docs sont pas à jours et/ou mélangent plusieurs versions ....

L'IA elle va te sortir un truc "plausible" mais ce sera de la merde.

Il faut pas croire que tout ça est sans efforts et se fait facilement.

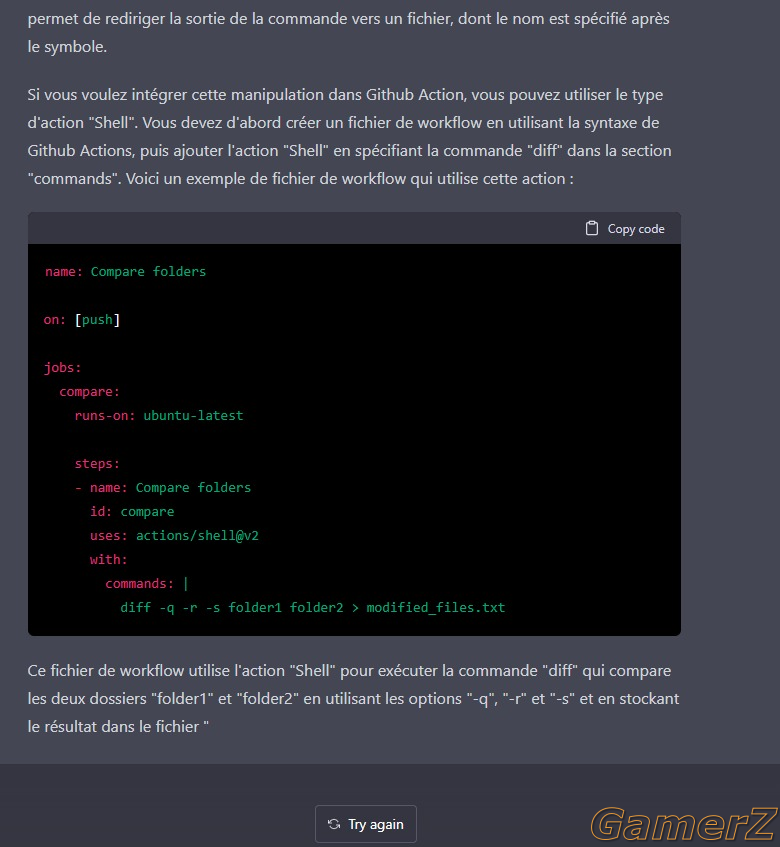

Il faut entraîner le modèle avec de BONNES données.

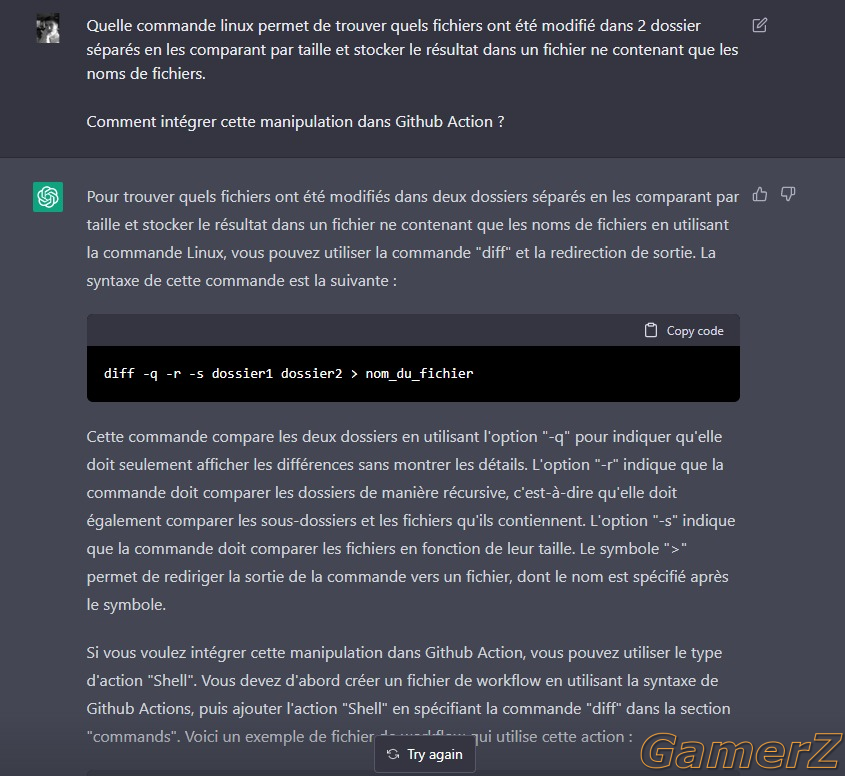

Ici ça parait facile car ils se basent sur un ENORME input de toute la "communauté" et donc statistiquement ça doit aider à balayer les erreurs.

Si le seul peye qui entraine le modèle de ta FAQ HR c'est Gérard "rien à battre", ben t'auras quand même un chatbox de merde